La Paula Cáceres és responsable d’incidència d’AlgoRace, un projecte de l’Estat espanyol que té com a objectiu aportar perspectiva antiracista al debat sobre la IA, acostant-lo a les comunitats migrants i racialitzades.

Què és AlgoRace i per què neix?

Sorgeix amb l’objectiu de posar damunt la taula el debat sobre la relació que hi ha entre tecnologies i intel·ligència artificial i reproducció de racisme i colonialisme. En alguns sectors del moviment antiracista de Madrid parlàvem que no estàvem sent part del debat sobre l’ús de tecnologies a la frontera per impedir el dret a migrar i sobre la manca d’una mirada antiracista al tema. Però, és clar, a l’antiracisme sempre tenim qüestions molt més urgents i immediates que atendre, com ara la lluita pel tancament dels CIE, la denúncia dels controls policials per perfil ètnico-racial, la visibilització de tot el que passa a la frontera sud… Fins que, arribat un moment, vam tenir l’oportunitat de rebre finançament per iniciar AlgoRace.

Què et va dur a implicar-te en un projecte com AlgoRace?

Llegíem sobre l’ús de tecnologies de reconeixement facial que estaven perjudicant persones racialitzades: primer perquè són tecnologies que no funcionen bé i segon perquè es fan servir per criminalitzar. I ens adonàvem que no hi havia veus racialitzades parlant-ne. Les veus que hi havia eren sobretot de persones acadèmiques i no racialitzades.

Per fer aquesta revista hem apostat per persones que no siguin homes, blancs i de classe benestant, etc., per intentar sortir del pensament des d’on han estat concebudes les TRIC (Tecnologies de la Relació, Informació i Comunicació) i la IA (Intel·ligència Artificial). Com funciona un algorisme? És possible la neutralitat?

La primera cosa que em sembla important assenyalar és que no hi pot haver neutralitat darrere d’una tecnologia on hi ha persones. Els algorismes es dissenyen i s’entrenen, i això ho fan persones. És impossible que hi hagi neutralitat perquè totes treballem des dels nostres punts de vista. I com que la majoria de les grans tecnològiques que generen aquests algorismes estan formades per homes blancs de classe mitjana amb un determinat estatus socioeconòmic, podem imaginar-nos el tipus de mirada que hi ha al darrere. Per tant, la resposta és que no hi ha algorismes neutrals.

Recordo l’entrevista de l’investigador peruà Omar Flores, que ha treballat en el camp de la intel·ligència artificial a Silicon Valley i a Twitter, en què deia que tot algorisme és un punt de vista, i ho deia una persona que treballava amb algorismes. Tot algorisme és un punt de vista perquè és la creació d’una persona que, amb tots els seus biaixos a sobre: de classe, de gènere, ètnic racial…

Aleshores, quan diem que la IA és racista i sexista, estem dient que ha estat desenvolupada i entrenada per persones racistes i sexistes que reprodueixen el racisme i el sexisme estructural.

Estem dient que aquestes persones estan reproduint biaixos racistes i sexistes que formen part dels propis biaixos individuals, influïts pel context polític, social i econòmic mundial en què es produeixen aquestes tecnologies: heteropatriarcal, racista, sexista. O sigui que, d’una banda, tenim la mirada individual que té la persona o el cap que mana a aquesta persona desenvolupar l’algorisme i, de l’altra banda, hi ha el context polític, econòmic i social del sistema món que també és heteropatriarcal, sexista, classista, grassòfob i molt més.

L’algorisme no sempre és Intel·ligència Artificial, oi?

Perquè un sistema algorítmic es consideri IA ha de ser capaç d’aprendre de si mateix perquè ell mateix es vagi autoafinant i autocorregint. Un algorisme és qualsevol sistema compost per una sèrie de passos per arribar a una tasca final; per exemple, una recepta de cuina és un algorisme. La IA té l’afegit de l’autocorrecció. El que hem de saber és que s’utilitzen constantment sistemes algorítmics sense que nosaltres ens n’adonem: s’estan fent servir en processos de selecció de personal, per exemple, com el que va utilitzar Amazon.

Què va passar amb l’algorisme d’Amazon?

Doncs que va ser “entrenat” sobre la base de les persones que en el passat havien format part dels equips directius d’Amazon per tal que així, quan arribessin els currículums, es triessin els perfils més semblants. Què va passar? Doncs que, com que vivim en un sistema patriarcal, masclista, racista… les persones que en el passat havien ocupat aquests càrrecs eren homes, blancs, amb un nivell d’estudis determinat, etc. Així l’algorisme excloïa directament els qui no encaixaven.

Tens més exemples d’algorismes que funcionen a la nostra vida?

A Catalunya hi ha el RisCanvi, que és un algorisme que s’utilitza per determinar a quines persones els donaran un benefici penitenciari i també per determinar factors de risc en la reincidència en el delicte. Hi ha una recerca molt bona d’El Confidencial en què s’esmicola com funciona l’algorisme, que conclou que acaba penalitzant els qui provenen de contextos migratoris, de situacions familiars complexes i de vulnerabilitat… És a dir, factors que en teoria haurien de ser atenuants i, per tant, factors per prestar més ajuda a la persona acaben sent factors penalitzadors. El que és greu de RisCanvi és que, de vegades, es prioritza la decisió algorítmica davant de la d’un equip de persones, educadores, advocades, psicòlogues… Justament a El Confidencial es relatava un cas en què l’equip humà alertava de certes contradiccions en l’algorisme i, tot i així, la decisió que va prioritzar el jutjat va ser la de RisCanvi.

Un altre algorisme és el de Seguiment Integral en els casos de Violència de Gènere, més conegut com a VioGen, que s’aplica a les dones que acudeixen a una comissaria a denunciar una agressió masclista i que determina el risc de patir violència de nou. El problema és, novament, que es prenen decisions judicials d’ordre d’allunyament o no sobre la base d’aquest algorisme. De fet, s’han conegut diversos casos de dones que eren dins del sistema VioGen, però que no van rebre mesures de protecció i van acabar sent assassinades pels seus agressors. L’últim va passar el febrer d’aquest any a Màlaga .

Què són i en què consisteixen els sistemes de control biomètric?

Hi ha diverses tecnologies d’IA que es fan servir en diferents àmbits. Unes són els sistemes d’identificació biomètrica, un sistema de reconeixement facial mitjançant càmeres que s’instal·len en tota classe de dispositius. Aquests sistemes estan instal·lats en telèfons mòbils, portàtils, etc. per reconèixer el rostre de les persones i facilitar, així, certes gestions, com ara tràmits de banca en línia. Quin és el problema d’aquesta tecnologia? Doncs que dona molts errors en cares de persones no caucàsiques. L’Institut Nacional d’Estàndards i Tecnologia dels Estats Units va fer un estudi força extens on van provar aquestes tecnologies i algorismes, analitzant milions d’imatges, i la conclusió a què van arribar va ser que la majoria donaven errors a la cara de persones asiàtiques i negres, amb falsos positius (dues persones diferents eren llegides com la mateixa persona) i falsos negatius (és a dir, dues imatges de la mateixa persona eren llegides com a persones diferents).

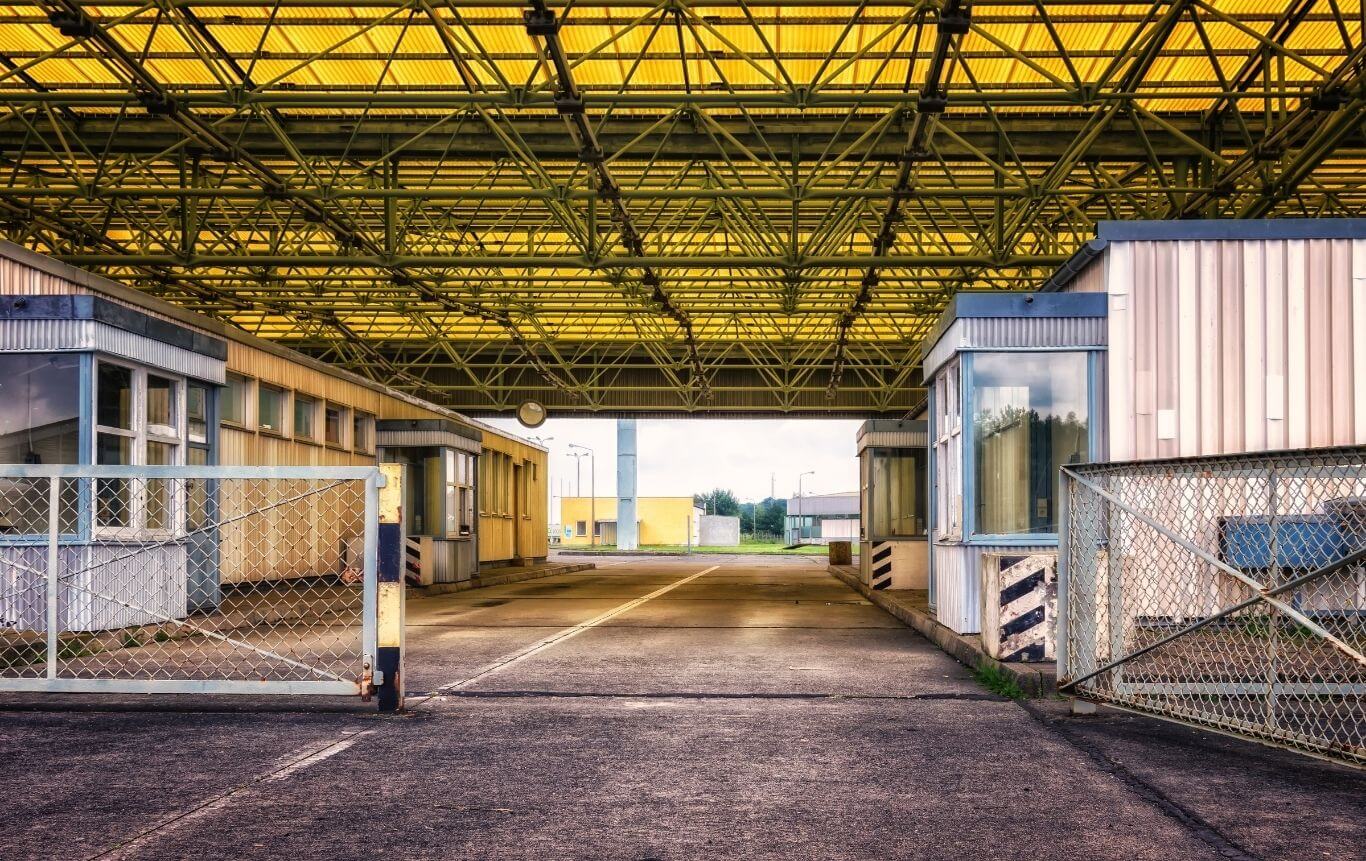

La investigadora del MIT Joy Buolamwini va descobrir que diversos programes de reconeixement facial no podien “llegir” la seva cara, tret que portés una màscara blanca. A partir d’aquí va començar a investigar aquest tema i va acabar creant la Lliga de la Justícia Algorítmica. Tot això ens indica que aquesta tecnologia no és precisa, no és exacta i provoca errors; però tanmateix és una tecnologia que començarà a implantar-se a les famoses fronteres intel·ligents a diferents llocs de la Unió Europea.

I encara que és una tecnologia que sabem que comet errors se segueix aplicant…

De fet, la regulació sobre intel·ligència artificial realitzada pel Parlament Europeu situa les tecnologies de reconeixement facial com a perilloses i es recomana no utilitzar-les; tot i així, la mateixa llei deixa un buit i obre la porta a fer-la servir en un context fronterer, defensant la lluita contra el terrorisme i la necessitat de garantir la seguretat nacional.

Llegia en un article de la periodista María Sánchez que, el 2023, es van comptabilitzar almenys cinc detencions policials errònies basades en sistemes de reconeixement facial als Estats Units. Les cinc persones eren homes negres. L’ús del reconeixement facial afecta d’una manera desproporcionada les persones racialitzades. Ens pots donar més exemples de com s’han perpetuat aquests patrons d’exclusió i opressió amb persones racialitzades, a través de la IA?

Mira, un dels problemes en què ens trobem més és la dificultat per obtenir exemples concrets. Primer perquè hi ha molta opacitat i la majoria de nosaltres no sabem quin tipus d’algorismes es fan servir ni en quines àrees. En segon lloc, perquè quan una persona n’ha estat víctima, no necessàriament s’identifica com a tal, només perquè ho ha normalitzat (pensant, per exemple, que s’ha quedat fora d’una selecció de personal perquè no coincideix amb el perfil i no perquè l’algorisme l’hagi exclòs per ser migrant, per exemple). I en tercer lloc, perquè algunes persones que saben que han estat víctimes d’un sistema com aquest no volen comentar-ho i exposar-lo públicament.

Hi ha dos llibres que recullen exemples i casos de persones perjudicades per l’ús d’algorismes, Armas de destrucción matemática, de Cathy O’Neil, i La automatización de la desigualdad, de Virginia Eubanks.

Quines altres tecnologies aplicades al control hi ha?

Hi ha una tecnologia per reconèixer les olors vinculades a determinades emocions. Es tracta d’un projecte pilot anomenat Sniffer i ja s’està provant en alguns països. Aquesta tecnologia identifica, per exemple, una determinada olor corporal lligada a la por. Així, si per exemple aquesta olor es detecta en un territori fronterer, es pot interpretar que aquesta persona està travessant aquesta frontera de manera il·legal.

També hi ha altres tecnologies de reconeixement d’emocions: l’escola pública San Blas de Málaga va participar en el pilot de reconeixement d’emocions a l’aula, que va consistir a instal·lar càmeres per avaluar el material didàctic utilitzat. Així, si s’observa que una part de l’alumnat està distreta, es pot deduir que el material educatiu no és correcte. El principal error d’on parteix aquest projecte és que les emocions són universals: com podem saber que una determinada expressió facial correspon a la mateixa emoció en totes les persones? Això no es pot saber! Les cares no responen igual a les mateixes emocions internes: un alumne que mira al sostre no significa necessàriament que estigui distret, potser simplement pensa en el que li està explicant el professor.

Com impacten aquestes tecnologies en els drets de les persones migrades i racialitzades?

Amplificant les discriminacions històriques, amb l’afegit que és més difícil identificar-les i amb l’afegit també que no hi ha cap instància a la qual reclamar. Per tant, amplifica el racisme, el masclisme, el sexisme, la LGBTIfòbia, etc., i et deixa sense queixes i eines de visibilitat.

Hi ha, per exemple, un sistema que funciona a les comissaries de l’Estat espanyol, que és l’algorisme Veripol, creat per detectar denúncies falses. S’utilitza, per exemple, en les denúncies de robatoris de telèfons mòbils i ajuda a detectar possibles denúncies falses vinculades al cobrament d’assegurances. Aquí es va entrenar l’algorisme amb un conjunt de dades de poc més d’un miler de denúncies analitzades per un agent de policia i alerta d’una possible denúncia falsa quan, per exemple, es posa molt èmfasi en la marca del mòbil o quan s’esmenta la paraula “navalla”. Això sense tenir en compte que hi ha persones per a qui tenir una determinada marca de mòbil pot ser molt rellevant o que en determinats països la paraula “navalla” és molt més usada que la paraula “ganivet”. En aquests casos la denúncia serà descartada, però sense que a la persona se li digui que ha estat per això. I no sabrà que, com que va fer servir un determinat llenguatge, la seva denúncia es va arxivar.

Potser tu mateixa t’ha vist afectada per un sistema algorítmic i no ho saps: com que ets dona o migrant o mare soltera pots ser descartada quan vas a demanar un crèdit. I no en tindràs ni idea. I encara que ho sabessis, quina és la instància on pots acudir a reclamar?

Per veure com aquesta estructura tecnològica de què parles es converteix en una arma de guerra i control de la població, tenim l’exemple del genocidi palestí i de com l’estat d’Israel utilitza la IA per reforçar el control de fronteres, el control de la població i el desplegament d’operacions militars. Pots explicar més coses sobre aquesta infraestructura tecnològica de control i repressió colonials?

Totes aquestes tecnologies de control facial, ús de drons, etc. són denunciades a l’informe d’Amnistia Internacional Apartheid automatizado: Cómo se fragmenta, segrega y controla a la población palestina en los TPO mediante el reconocimiento facial. És impressionant veure com s’identificava les persones palestines per accedir a les seves cases i als seus barris.

Aquest algorisme racista i masclista també funciona a les xarxes socials. Ens pots donar exemples de com les xarxes socials generen i permeten la violència en entorns digitals i censuren continguts?

Mira, és molt conegut el cas de Facebook, en què els negres en alguns vídeos eren etiquetats com a primats. Això va ser perquè l’algorisme es va entrenar principalment amb rostres de persones blanques. I encara que Facebook va sortir i es va disculpar, el que va passar és que, de nou, tota una comunitat de persones i col·lectius històricament deshumanitzats, animalitzats, etc. van tornar a veure com es feia el mateix, és a dir, com se’ls deshumanitzava i se’ls discriminava, ara a través de les tecnologies a les xarxes socials.

Un altre cas denunciat és l’ús dels anomenats filtres de “bellesa”, que bàsicament afegeixen una pàtina blanca, és a dir, aclareixen la pell.

Quan Facebook etiqueta persones negres com a primats o quan una persona negra fa servir un filtre de bellesa i el filtre li il·lumina la pell; o quan l’algorisme, a mi que soc dona, em mostra anuncis d’electrodomèstics o de receptes de cuina, darrere hi ha persones que estan reproduint discriminacions històriques.

Tinc un article, “Ser mujer en tiempos de IA. Cuando tu jefe es el algoritmo”, en què parlo de com Linkedin, per exemple, presenta més ofertes ben remunerades als homes que a les dones o directament no presenta certes ofertes de determinats llocs de treball a les dones.

- QUADERN RELACIONAT

FRAGMENT EXTRET DEL QUADERN

La Llei de la intel·ligència artificial és una bona eina per evitar l’opacitat de la IA i els algorismes? Hi pot haver un marc normatiu que ens protegeixi d’aquests usos de la IA?

Crec que la Llei d’IA que es va aprovar al Parlament Europeu és un pas important i constitueix un avenç perquè permetrà, entre altres coses, que hi hagi una base de dades comuna d’algorismes que s’estan utilitzant, i això posarà fi a l’opacitat que tenim avui, en què no sabem quin algorisme s’utilitza i en quines situacions, perquè requerirà que els països tinguin un registre d’algorismes on entitats públiques i empreses que els utilitzin ho hauran de notificar. D’altra banda, es farà una observació especial sobre l’ús d’algorismes perillosos que poden afectar els drets fonamentals de les persones; s’impedirà el reconeixement facial directe a l’espai públic. I tot això és positiu.

El problema és que aquesta llei acaba creant una mena de regulació paral·lela en contextos fronterers, i això és greu perquè a una part de la població sí que li reconeixen uns drets, però a una altra no.

I precisament no es reconeixen a una població que, per la seva situació, hauria de ser tractada amb més cura i atenció…

Exactament. I, no obstant, tots aquests factors que haurien de ser de més atenció acaben sent penalitzadors. A la frontera, per exemple, és possible implementar el que avui és el projecte pilot Sniffer, que he comentat abans.

La llei europea ni tan sols esmenta l’ús de drons a la frontera, per exemple. La creació d’aquesta normativa paral·lela respon a aquesta suposada seguretat nacional i protecció contra el terrorisme. Però el que passa aquí és que, una vegada més, les lleis que fa la Unió Europea creen categories de persones: hi ha persones de primer ordre, a qui protegim i garantim drets, i d’altres que considerem de manera diferent, deshumanitzem, i creiem que no mereixen la mateixa protecció.

I és en aquest sentit que, des d’AlgoRace, afirmem que la Llei d’IA del Parlament Europeu no protegeix els drets de les persones migrants i racialitzades en matèria d’IA i tecnologies.

Evitar aquesta duplicació de la llei, doncs, seria un bon mecanisme per evitar el tall racista de l’IA. Quins altres mecanismes podríem establir?

Disposar d’organitzacions integrades per la societat civil, que vigilin el desenvolupament i la implantació d’aquest tipus de tecnologies, i que puguin fer auditories externes d’aquests sistemes.

A Espanya hi ha la SEDIA (Secretaría Española de Inteligencia Artificial); després hi ha l’AESIA (Agencia Española de Supervisión de la Inteligencia Artificial) i d’aquesta en sortirà l’Observatori d’Intel·ligència Artificial, on hauria d’estar present la societat civil, per ser una entitat vigilant dels sistemes algorítmics.

Hauríem de tenir entitats amb finançament públic –perquè la realitat és que no hi ha diners de col·lectius i organitzacions per crear-les–, integrades per la societat civil, que fessin d’observadores, vigilants i supervisores d’aquests sistemes. Aquests observatoris haurien d’estar formats no solament per persones amb perfils súper tècnics (matemàtics, enginyers, màsters en IA, etc.), sinó també per persones amb perfils diferents, que treballin en aquest àmbit des d’una perspectiva social i crítica.

Una altra alternativa és la que ja estem fent: que hi hagi organitzacions com AlgoRace, com Algorights, com Civio, com Riders x Rights, o AI Citizen, etc. El problema és que tenim pocs recursos i estem fent molt, però és poc en relació amb tot el que cal.

Et proposo un exercici d’imaginació utòpica. Com seria una IA que estigués al servei de la justícia social i de superar el sistema d’opressió en què vivim? Com ho faries per posar-la al servei de l’emancipació de totes les persones i d’un sistema ecosocial just?

Crec que tota aquesta àrea de desenvolupament tecnològic, algorismes i IA serà cada cop més important. És absurd tenir un discurs que hi vagi en contra. Tot i així, diria que hi ha certs àmbits que tenen a veure amb els drets fonamentals de les persones en què no s’hauria de fer servir la IA, sinó equips humans interdisciplinaris formats per persones que estan d’alguna manera vinculades al tema que estem tractant.

En segon lloc, sempre hi hauria d’haver la possibilitat de fer auditories externes. Hi hauria d’haver transparència en la manera com s’ha dissenyat i entrenat l’algorisme i que es pugui accedir al codi font.

I, finalment, que hi hagi més visibilitat sobre el seu ús. Que se’ns avisi sempre de l’ús de sistemes algorítmics en els processos que ens afecten.

Aquesta entrevista està publicada en la Revista d’Opcions número 68 Tecnologies digitals i internet. Cap a la sobirania tecnològica dins dels límits planetaris. Si la vols llegir, la pots comprar o unir-te a Opcions.