Paula Cáceres es responsable de incidència de AlgoRace, un proyecto del Estado español que tiene como objetivo aportar perspectiva perspectiva antirracista en el debate sobre la IA, acercándolo en las comunidades migrantes y racializadas.

¿Qué es AlgoRace y por qué y para qué nace?

Surge con el objetivo de poner encima la mesa el debate sobre la relación que hay entre tecnologías e inteligencia artificial y la reproducción de racismo y colonialismo. En algunos sectores del movimiento antirracista de Madrid hablábamos que no estábamos siendo parte del debate sobre el uso de tecnologías en la frontera para impedir el derecho a migrar y sobre la carencia de una mirada antirracista. Pero, está claro, en el antirracismo siempre tenemos cuestiones mucho más urgentes e inmediatas que atender, como por ejemplo la lucha por el cierre de los CIE, la denuncia de los controles policiales por perfil étnico-racial, la visibilización de todo lo que pasa en la frontera sur… Hasta que, llegado un momento, tuvimos la oportunidad de recibir financiación para iniciar AlgoRace.

¿Qué te llevó a implicarte en un proyecto como AlgoRace?

Leíamos sobre el uso de tecnologías de reconocimiento facial que estaban perjudicando personas racializadas: primero porque son tecnologías que no funcionan bien y segundo porque se usan para criminalizar. Y nos dábamos cuenta que no había voces racializadas hablando. Las voces que había eran sobre todo de personas académicas y no racializadas.

Para hacer esta revista hemos apostado por personas que no sean hombres, blancos y de clase acomodada, etc., para intentar salir del pensamiento desde dónde han sido concebidas las TRIC (Tecnologías de la Relación, Información y Comunicación) y la IA (Inteligencia Artificial). ¿Cómo funciona un algoritmo? Es posible la neutralidad?

La primera cosa que me parece importante señalar es que no puede haber neutralidad detrás de una tecnología donde hay personas. Los algoritmos se diseñan y se entrenan, y esto lo hacen personas. Es imposible que haya neutralidad porque todas trabajamos desde nuestros puntos de vista. Y como que la mayoría de las grandes tecnológicas que generan estos algoritmos están formadas por hombres blancos de clase media con un determinado estatus socioeconómico, podemos imaginarnos el tipo de mirada que hay detrás. Por lo tanto, la respuesta es que no hay algoritmos neutrales.

Recuerdo la entrevista del investigador peruano Omar Flores, que ha trabajado en el campo de la inteligencia artificial en Silicon Valley y en Twitter, en la que decía que todo algoritmo es un punto de vista. Todo algoritmo es un punto de vista porque es la creación de una persona con todos sus sesgos encima: de clase, de género, étnico-racial…

Entonces, cuando decimos que la IA es racista y sexista, estamos diciendo que ha sido desarrollada y entrenada por personas racistas y sexistas que reproducen el racismo y el sexismo estructural.

Estamos diciendo que estas personas están reproduciendo sesgos racistas y sexistas que forman parte de los propios sesgos individuales, influidos por el contexto político, social y económico mundial en que se producen estas tecnologías: heteropatriarcal, racista, sexista. O sea que, por un lado, tenemos la mirada individual que tiene la persona o el jefe que manda a esta persona desarrollar el algoritmo y, del otro lado, hay el contexto político, económico y social del sistema mundial, que también es heteropatriarcal, sexista, clasista, gordófobo y mucho más.

El algoritmo no siempre es Inteligencia Artificial, ¿verdad?

ePara que un sistema algorítmico se considere IA tiene que ser capaz de aprender de sí mismo porque él mismo se vaya autoafinando y autocorrigiendo. Un algoritmo es cualquier sistema compuesto por una serie de pasos para llegar a una tarea final; por ejemplo, una receta de cocina es un algoritmo. La IA tiene el añadido de la autocorrección. Lo que tenemos que saber es que se utilizan constantemente sistemas algorítmicos sin que nosotros nos damos cuenta: se están usando en procesos de selección de personal, por ejemplo, como el que utilizó Amazon.

¿Qué pasó con el algoritmo de Amazon?

Pues que fue “entrenado” en base a las personas que en el pasado habían formado parte de los equipos directivos de Amazon para que así, cuando llegaran los currículums, se eligieran los perfiles más parecidos. ¿Qué pasó? Pues que, como vivimos en un sistema patriarcal, machista, racista… las personas que en el pasado habían ocupado estos cargos eran hombres, blancos, con un nivel de estudios determinado, etc. Así el algoritmo excluía directamente quienes no encajaban.

¿Tienes más ejemplos de algoritmos que funcionan en nuestra vida?

En Cataluña hay el RisCanvi, que es un algoritmo que se utiliza para determinar a qué personas les darán un beneficio penitenciario y también para determinar factores de riesgo en la reincidencia en el delito. Hay una investigación muy buena de El Confidencial en el que se desmenuza cómo funciona el algoritmo y concluye que acaba penalizando quienes provienen de contextos migratorios, de situaciones familiares complejas y de vulnerabilidad… Es decir, factores que en teoría tendrían que ser atenuantes y, por lo tanto, factores para prestar más ayuda a la persona, acaban siendo factores penalizadores. Lo que es grave de RisCanvi es que, a veces, se prioriza la decisión algorítmica ante la de un equipo de personas, educadoras, abogadas, psicólogas… Justamente El Confidencial se relataba un caso en el que el equipo humano alertaba de ciertas contradicciones en el algoritmo y, aun así, la decisión que priorizó el juzgado fue la de RisCanvi.

Otro algoritmo es el de Seguimiento Integral en los casos de violencia de género, más conocido como VioGen, que se aplica a las mujeres que acuden a una comisaría a denunciar una agresión machista y que determina el riesgo de sufrir violencia de nuevo. El problema es, nuevamente, que se toman decisiones judiciales de orden de alejamiento o no en base a este algoritmo. De hecho, se han conocido varios casos de mujeres que eran dentro del sistema VioGen, pero que no recibieron medidas de protección y acabaron siendo asesinadas por sus agresores. El último pasó el febrero de este año en Málaga .

¿Qué son y en qué consisten los sistemas de control biométrico?

Hay varias tecnologías de IA que se usan en diferentes ámbitos. Unas son los sistemas de identificación biométrica, un sistema de reconocimiento facial mediante cámaras que se instalan en toda clase de dispositivos. Estos sistemas están instalados en teléfonos móviles, portátiles, etc. para reconocer el rostro de las personas y facilitar, así, ciertas gestiones, como por ejemplo trámites de banca en línea. ¿Cuál es el problema de esta tecnología? Pues que da muchos errores en caras de personas no caucásicas. El Instituto Nacional de Estándares y Tecnología de los Estados Unidos hizo un estudio bastante extenso donde probaron estas tecnologías y algoritmos, analizando millones de imágenes, y la conclusión a que llegaron fue que la mayoría daban errores a la cara de personas asiáticas y negras, con falsos positivos (dos personas diferentes eran leídas como la misma persona) y falsos negativos (es decir, dos imágenes de la misma persona eran leídas como personas diferentes).

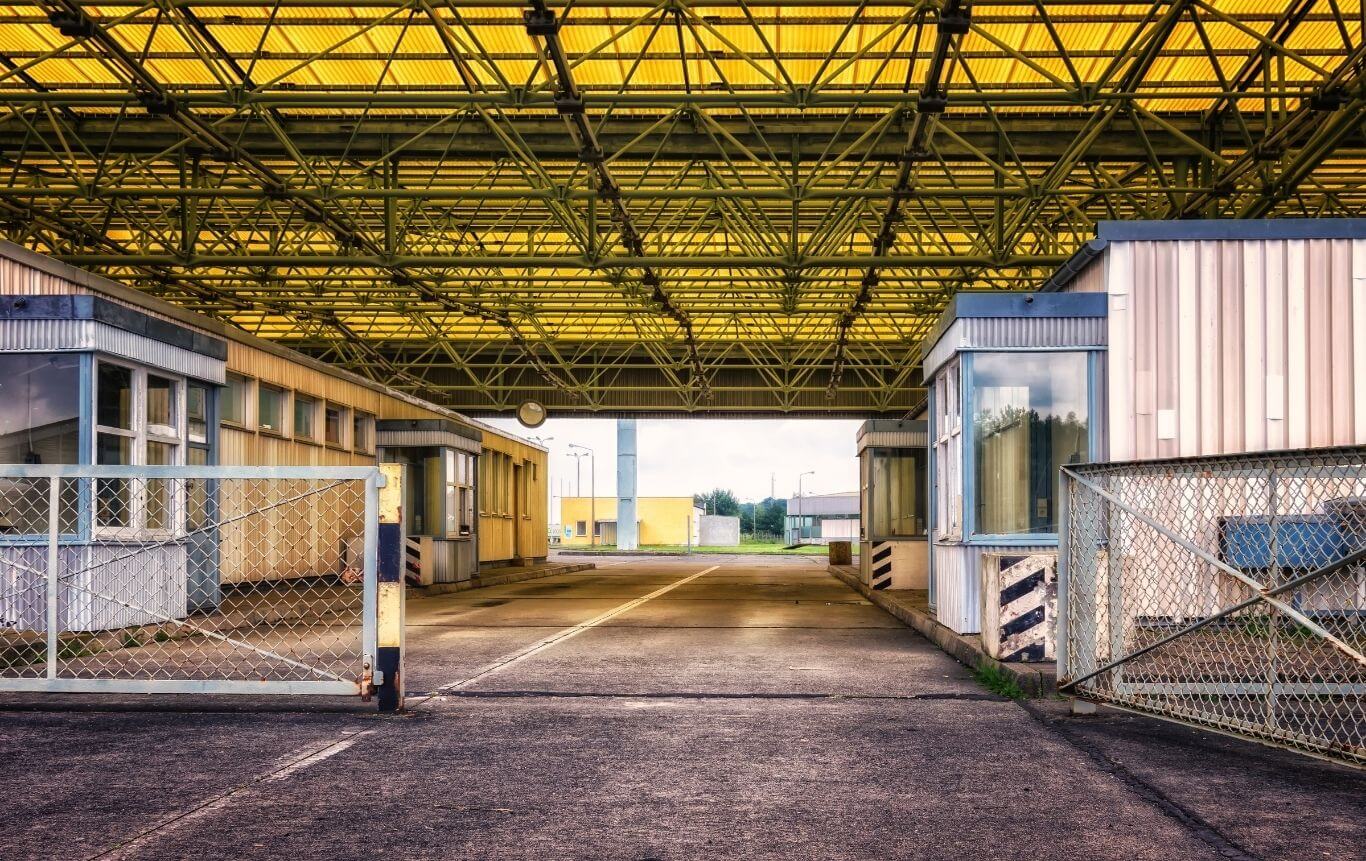

La investigadora del MIT Joy Buolamwini descubrió que varios programas de reconocimiento facial no podían “leer” su cara, salvo que llevara una máscara blanca. A partir de aquí empezó a investigar este tema y acabó creando la Lliga de la Justícia Algorítmica. Todo esto nos indica que esta tecnología no es precisa, no es exacta y provoca errores; pero aun así es una tecnología que empezará a implantarse en las famosas fronteras inteligentes a diferentes lugares de la Unión Europea.

Y aunque es una tecnología que sabemos que comete errores se sigue aplicando…

De hecho, la regulación sobre inteligencia artificial realizada por el Parlamento Europeo sitúa las tecnologías de reconocimiento facial como peligrosas y se recomienda no utilizarlas; aun así, la misma ley deja un vacío y abre la puerta a usarla en un contexto fronterizo, defendiendo la lucha contra el terrorismo y la necesidad de garantizar la seguridad nacional.

Leía en un artículo de la periodista María Sánchez que el 2023 se contabilizaron al menos cinco detenciones policiales erróneas basadas en sistemas de reconocimiento facial en los Estados Unidos. Las cinco personas eran hombres negros. El uso del reconocimiento facial afecta de una manera desproporcionada las personas racializadas.

¿Nos puedes dar más ejemplos de cómo se han perpetuado estos patrones de exclusión y opresión con personas racializadas, a través de la IA?

iMira, uno de los problemas que más nos encontramos es la dificultad para obtener ejemplos concretos. Primero porque hay mucha opacidad y la mayoría de nosotros no sabemos qué tipo de algoritmos se usan ni en qué áreas. En segundo lugar, porque cuando una persona ha sido víctima, no necesariamente se identifica como tal, porque lo ha normalizado (pensando, por ejemplo, que se ha quedado fuera de una selección de personal porque no coincide con el perfil y no porque el algoritmo lo haya excluido por ser migrante, por ejemplo). Y en tercer lugar, porque algunas personas que saben que han estado víctimas de un sistema como este no quieren comentarlo y exponerlo públicamente.

Hay dos libros que recogen ejemplos y casos de personas perjudicadas por el uso de algoritmos, Armas de destrucción matemática, de Cathy O’Neil, y La automatización de la desigualdad, de Virginia Eubanks.

¿Qué otras tecnologías aplicadas al control hay?

Hay una tecnología para reconocer los olores vinculados a determinadas emociones. Se trata de un proyecto piloto llamado Sniffer y ya se está probando en algunos países. Esta tecnología identifica, por ejemplo, un determinado olor corporal ligada al miedo. Así, si por ejemplo este olor se detecta en un territorio fronterizo, se puede interpretar que esta persona está atravesando esta frontera de manera ilegal.

También hay otras tecnologías de reconocimiento de emociones: la escuela pública San Blas de Málaga participó en el piloto de reconocimiento de emociones en el aula, que consistió en instalar cámaras para evaluar el material didáctico utilizado. Así, si se observa que una parte del alumnado está distraída, se puede deducir que el material educativo no es correcto. El principal error de donde parte este proyecto es que las emociones son universales: ¿cómo podemos saber que una determinada expresión facial corresponde a la misma emoción en todas las personas? ¡Esto no se puede saber! Las caras no responden igual a las mismas emociones internas: un alumno que mira al techo no significa necesariamente que esté distraído, quizás simplemente piensa en lo que le está explicando el profesor.

¿Cómo impactan estas tecnologías en los derechos de las personas migradas y racializadas?

Amplificando las discriminaciones históricas, con el añadido que es más difícil identificarlas y con el añadido también que no hay ninguna instancia a la cual reclamar. Por lo tanto, amplifica el racismo, el machismo, el sexismo, la LGBTIfobia, etc., y te deja sin quejas y herramientas de visibilidad.

Hay, por ejemplo, un sistema que funciona en las comisarías del Estado español, que es el algoritmo Veripol, creado para detectar denuncias falsas. Se utiliza, por ejemplo, en las denuncias de robos de teléfonos móviles y ayuda a detectar posibles denuncias falsas vinculadas al cobro de seguros. Aquí se entrenó el algoritmo con un conjunto de datos de poco más de un millar de denuncias analizadas por un agente de policía y alerta de una posible denuncia falsa cuando, por ejemplo, se pone mucho énfasis en la marca del móvil o cuando se menciona la palabra “navaja”. Esto sin tener en cuenta que hay personas para quién tener una determinada marca de móvil puede ser muy relevante o que en determinados países la palabra “navaja” es mucho más usada que la palabra “cuchillo”. En estos casos la denuncia será descartada, pero sin que a la persona se le diga que ha sido por eso. Y no sabrá que, como usó un determinado lenguaje, su denuncia se archivó.

Quizás tú misma te ha visto afectada por un sistema algorítmico y no lo sabes: como eres mujer o migrante o madre soltera puedes ser descartada cuando vas a pedir un crédito. Y no tendrás ni idea. Y aunque lo supieras, ¿cuál es la instancia donde puedes acudir a reclamar?

Para ver como esta estructura tecnológica de la que hablas se convierte en una arma de guerra y control de la población, tenemos el ejemplo del genocidio palestino y de como el Estado de Israel utiliza la IA para reforzar el control de fronteras, el control de la población y el despliegue de operaciones militares. ¿Puedes explicar más cosas sobre esta infraestructura tecnológica de control y represión coloniales?

Todas estas tecnologías de control facial, uso de drones, etc. son denunciadas en el informe de Amnistía Internacional Apartheid automatizado: Cómo se fragmenta, segrega y controla a la población palestina en los TPO mediante el reconocimiento facial.Es impresionante ver cómo se identificaba las personas palestinas para acceder en sus casas y en sus barrios.

Este algoritmo racista y machista también funciona en las redes sociales. ¿Nos puedes dar ejemplos de como las redes sociales generan y permiten la violencia en entornos digitales y censuran contenidos?

Mira, es muy conocido el caso de Facebook, donde los negros en algunos videos eran etiquetados como primates. Esto fue porque el algoritmo se entrenó principalmente con rostros de personas blancas. Y aunque Facebook salió y se disculpó, lo que pasó es que, de nuevo, toda una comunidad de personas y colectivos históricamente deshumanizados, animalitzados, etc. volvieron a ver como se hacía el mismo, es decir, como se los deshumanizaba y se los discriminaba, ahora a través de las tecnologías en las redes sociales.

Otro caso denunciado es el uso de los llamados filtros de “belleza”, que básicamente añaden una pátina blanca, es decir, aclaran la piel.

Cuando Facebook etiqueta personas negras como primates o cuando una persona negra usa un filtro de belleza y el filtro le ilumina la piel; o cuando el algoritmo, a mí que soy mujer, me muestra anuncios de electrodomésticos o de recetas de cocina, detrás hay personas que están reproduciendo discriminaciones históricas.

Tengo un artículo, “Ser mujer en tiempos de IA. Cuando tu jefe es el algoritmo ”, en el que hablo de cómo Linkedin, por ejemplo, presenta más ofertas muy remuneradas a los hombres que a las mujeres o directamente no presenta ciertas ofertas de determinados puestos de trabajo a las mujeres.

- CUADERNO RELACIONADO

FRAGMENTO EXTRAÍDO DEL CUADERNO

¿La Ley de la inteligencia artificial es una buena herramienta para evitar la opacidad de la IA y los algoritmos? ¿Puede haber un marco normativo que nos proteja de estos usos de la IA?

Creo que la Ley de IA que se aprobó en el Parlamento Europeo es un paso importante y constituye un adelanto porque permitirá, entre otras cosas, que haya una base de datos común de algoritmos que se están utilizando, y esto pondrá fin a la opacidad que tenemos hoy, que no sabemos qué algoritmo se utiliza y en qué situaciones, porque requerirá que los países tengan un registro de algoritmos donde entidades públicas y empresas que los utilicen lo tendrán que notificar. Por otro lado, se hará una observación especial sobre el uso de algoritmos peligrosos que pueden afectar los derechos fundamentales de las personas; se impedirá el reconocimiento facial directo en el espacio público. Y todo esto es positivo.

El problema es que esta ley acaba creando un tipo de regulación paralela en contextos fronterizos, y esto es grave porque a una parte de la población sí que le reconocen unos derechos, pero a otra no.

Y precisamente no se reconocen a una población que, por su situación, tendría que ser tratada con más cuidados y atención…

Exactamente. Y, no obstante, todos estos factores que tendrían que ser de más atención acaban siendo penalizadores. En la frontera, por ejemplo, es posible implementar lo que hoy es el proyecto piloto Sniffer, que he comentado antes.

La ley europea ni siquiera menciona el uso de drones en la frontera, por ejemplo. La creación de esta normativa paralela responde a esta supuesta seguridad nacional y protección contra el terrorismo. Pero lo que pasa aquí es que, una vez más, las leyes que hace la Unión Europea crean categorías de personas: hay personas de primer orden, a quien protegemos y garantizamos derechos, y otros que consideramos de manera diferente, deshumanizamos, y creemos que no merecen la misma protección.

Y es en este sentido que, desde AlgoRace, afirmamos que la Ley de IA del Parlamento Europeo no protege los derechos de las personas migrantes y racializadas en materia de IA y tecnologías.

Evitar esta duplicación de la ley, pues, sería un buen mecanismo para evitar el corte racista del IA. ¿Qué otros mecanismos podríamos establecer?

Disponer de organizaciones integradas por la sociedad civil, que vigilen el desarrollo y la implantación de este tipo de tecnologías, y que puedan hacer auditorías externas de estos sistemas.

En España hay SEDIA (Secretaría Española de Inteligencia Artificial); también la AESIA (Agencia Española de Supervisión de la Inteligencia Artificial) y de esta saldrá el Observatorio de Inteligencia Artificial, donde tendría que estar presente la sociedad civil, para ser una entidad vigilando de los sistemas algorítmicos.

Tendríamos que tener entidades con financiación pública –porque la realidad es que no hay dinero de colectivos y organizaciones para crearlas–, integradas por la sociedad civil, que hicieran de observadoras, vigilantes y supervisoras de estos sistemas. Estos observatorios tendrían que estar formados no solo por personas con perfiles súper técnicos (matemáticos, ingenieros, másteres en IA, etc.), sino también por personas con perfiles diferentes, que trabajen en este ámbito desde una perspectiva social y crítica.

Otra alternativa es la que ya estamos haciendo: que haya organizaciones como AlgoRace, como Algorights, como Civio, como Riders x Rights, o AI Citizen, etc. El problema es que tenemos pocos recursos y estamos haciendo mucho, pero es poco en relación con todo lo que hace falta.

Te propongo un ejercicio de imaginación utópica. ¿Cómo sería una IA que estuviera al servicio de la justicia social y de superar el sistema de opresión en el que vivimos? ¿Cómo lo harías para ponerla al servicio de la emancipación de todas las personas y de un sistema ecosocial justo?

Creo que toda esta área de desarrollo tecnológico, algoritmos y IA será cada vez más importante. Es absurdo tener un discurso que vaya en contra. Aun así, diría que hay ciertos ámbitos que tienen que ver con los derechos fundamentales de las personas en los que no se tendría que usar la IA, sino equipos humanos interdisciplinarios formados por personas que están de alguna manera vinculadas al tema que estamos tratando.

En segundo lugar, siempre tendría que haber la posibilidad de hacer auditorías externas. Tendría que haber transparencia en cómo se ha diseñado y entrenado el algoritmo y que se pueda acceder al código fuente.

Y, finalmente, que haya más visibilidad sobre su uso. Que se nos avise siempre del uso de sistemas algorítmicos en los procesos que nos afectan.

Esta entrevista está publicada en la Revista de Opcions número 68 Tecnologías digitales e internet. Hacia la soberanía tecnológica dentro de los límites planetarios . Si la quieres leer, la puedes comprar o unirte a Opcions.